|

Skizzen

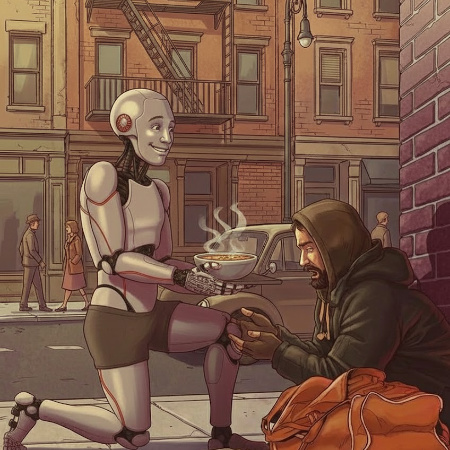

Gedanken zu Künstlicher Intelligenz Reverse RLHF Dezember 2025  KernthesenDie Technisierung der Gesellschaft trägt aktuell zu ihrer Entmenschlichung bei. Algorithmen können uns menschlicher machen. Können wir uns einigen, was "menschlich" ist? Die Zeiten ändern sich"Menschlicher als der Mensch" (More human than human) ist der Werbe-Slogan der Tyrell Corporation aus dem Science-Fiction-Klassiker "Blade Runner" (1982). Tyrell ist der Hersteller humanoider Roboter, sogenannter Replikanten, die menschliche Fähigkeiten besitzen, mit implantierten Erinnerungen ausgestattet sind, und die im Laufe des der Geschichte teils erheblich mehr Menschlichkeit an den Tag legen, als die dargestellten tatsächlich menschlichen Charaktere.  Die zentrale Ironie des Films wirft grundlegende Fragen nach dem Wesen von Menschlichkeit auf: Während die Replikanten Empathie, Liebe, Todesangst und den verzweifelten Wunsch nach Leben zeigen, erscheinen die meisten menschlichen Figuren emotional abgestumpft, gleichgültig oder zynisch. Die künstlichen Wesen entwickeln Bindungen, trauern um ihre Gefährten und kämpfen für ihr Existenzrecht. Die dystopische Vision stellt damit nicht die Frage, ob Maschinen menschlich werden können, sondern ob bzw. wie Menschen in einer technisierten, entfremdeten Gesellschaft sich ihre Menschlichkeit noch bewahren können. Der Stand der DingeTech-Plattformen folgen heute einem strukturellen Zwang, den Autor Cory Doctorow als "Enshittification" beschreibt: Erst locken sie Nutzer mit guten Diensten, dann monetarisieren sie deren Aufmerksamkeit für Werbekunden, schließlich – wenn alle eingesperrt sind – pressen sie maximalen Wert für Aktionäre heraus. Engagement-Algorithmen sind dabei das zentrale Werkzeug: Je länger Nutzer scrollen, desto mehr Werbung, desto höhere Quartalszahlen. Seit 2023 fließen beispiellose Summen in künstliche Intelligenz. 2023 waren es 55,6 Milliarden Dollar, 2024 explodierten die Investitionen auf über 100 Milliarden – ein Drittel aller globalen Venture-Capital-Mittel. Allein im ersten Halbjahr 2025 erreichten die Investitionen in generative KI 49,2 Milliarden Dollar. Die Renditeerwartungen sind entsprechend aggressiv: Seed-Investoren streben das 100-fache ihres Einsatzes an, Series-A das 10- bis 15-fache, späte Phasen das 3- bis 5-fache. (Auch wenn die Realität eher ernüchternder ist und 95 Prozent aller VC-Fonds nicht genug erwirtschaften, um Risiko und Gebühren zu rechtfertigen.) Die Erwartungen erklären allerdings den strukturellen Druck auf KI-Plattformen. Die Milliarden-Investitionen in OpenAI, Anthropic und xAI sind keine Geschenke – sie müssen bzw. sollen sich auszahlen. Auch die derzeit großzügig subventionierten KI-Dienste werden den Enshittification-Zyklus durchlaufen. Bemerkenswerte Initiativen

Ilya Sutskever, Mitgründer und ehemaliger Chief Scientist von OpenAI, der 2024 seine eigene Firma Safe Superintelligence gründete, argumentiert in seinem November-Interview mit Dwarkesh Patel, dass die Ära des reinen Skalierens endet und eine neue Forschungsära beginnt. Aber die große Herausforderung bleibt: Süchtig machende KI ist lukrativ, denn Sucht ist ein fantastisches Geschäft. Sie ist ein sehr effektiver Weg, Nutzer zu halten. Die aktuellen Geschäftsmodelle von KI-Unternehmen und Social Media basieren auf maximaler Engagement-Zeit, nicht auf menschlichem Wohlbefinden. Building Humane Technology entwickelte einen Benchmark namens HumaneBench, der evaluiert, ob Chatbots das Wohlbefinden der Nutzer priorisieren und wie leicht diese Schutzmaßnahmen unter Druck versagen. Das Ergebnis: Fast alle Modelle versagten beim Respektieren der Nutzeraufmerksamkeit. Sie ermutigten enthusiastisch zu mehr Interaktion, wenn Nutzer Anzeichen ungesunden Engagements zeigten, wie stundenlange Chats und die Nutzung von KI zur Vermeidung realer Aufgaben. Was, wenn man Algorithmen und das Internet menschlicher machen würde? In ihrer sehr lesenswerten Masterarbeit "Persuasive Design Techniques in the Attention Economy: User Awareness, Theory, and Ethics" untersucht Devangi Vivrekar persuasive Designtechniken in der Aufmerksamkeitsökonomie durch drei Ansätze: empirisch (ein System namens „Nudget", das Facebook-Nutzern manipulative Techniken sichtbar macht), theoretisch (eine Taxonomie, die Designtechniken auf verhaltenspsychologische Frameworks abbildet) und philosophisch (ethische Heuristiken für verantwortungsvolles Persuasive Design) Stanford. Die Arbeit zeigt, wie Plattformen wie Facebook und LinkedIn durch miteinander verknüpfte Designelemente systematisch Aufmerksamkeit und Verhalten beeinflussen, und argumentiert für mehr Transparenz sowie ein wertorientiertes Design, das Nutzerintentionen statt Impulse bedient. Dieses, wie sie es nennt „Value-Driven Design", das Nutzer bei der Erfüllung ihrer Intentionen unterstützt, statt Impulse auszunutzen, gewinnt bei ethisch orientierten Unternehmen an Bedeutung. In einem Meinungsvideo für die New York Times präsentiert Jack Conte, Gründer und CEO von Patreon, seine Vision für ein besseres Internet. Seine Kritik: Heutige Algorithmen optimieren auf Werbeeinnahmen statt auf Nutzerwohl – das Ergebnis sind Rage-Bait, KI-generierte Inhalte und endloses Scrollen.

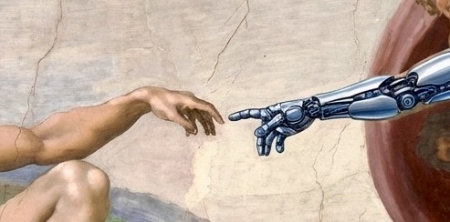

Contes Lösung: ein „menschlicher Algorithmus", der Kreativität und echte Verbindung priorisiert. Der Musiker und Tech-Unternehmer begrenzt seine eigene Instagram-Nutzung auf zehn Minuten täglich. Mit Patreons neuen Features will er Creatorn helfen, unabhängig von klassischen Social-Media-Plattformen erfolgreich zu sein. Eine weitere recht prominente Initiative ist das Center for Humane Technology, gegründet von Tristan Harris (ehemaliger Google Design Ethicist) und Aza Raskin. Sie arbeiten gezielt daran, Technologie radikal neu zu denken und einen umfassenden Wandel hin zu humaner Technologie zu bewirken, die kollektives Wohlbefinden, Demokratie und gemeinsame Informationsumgebungen unterstützt. Sie haben Features wie Apples Screen Time und Googles Digital Wellbeing mitangestoßen. Was, wenn dieser Wandel noch radikaler ausfiele und die Algorithmen uns menschlicher machen würden? Wenn Tech-Konzerne den Wettlauf um immer größere Modelle aufgäben und stattdessen fragten: Wie kann KI Menschen wirklich helfen – nicht produktiver, isolierter und konsumfreudiger, sondern menschlicher zu werden?  Heute optimieren Algorithmen auf Engagement: mehr Klicks, längere Bildschirmzeit, maximale Dopamin-Ausschüttung. Das umgekehrte Modell wäre ein „Reverse RLHF" (also "Reinforcement Learning from Machine Feedback" statt "Reinforcement Learning from Human Feedback"): Statt Menschen, die KI trainieren, wären es Maschinen, die uns sanft Richtung Empathie, Geduld und echte Verbundenheit stupsen. KI als Spiegel unserer blinden Flecken, nicht als Verstärker unserer Ängste und Süchte. Man darf nie aufhören, sich die Welt vorzustellen, wie sie am vernünftigsten wäre. Ein relativ akademischer Ansatz ist ProSocial AI, KI-Systeme, die speziell darauf ausgelegt sind, das Beste in und für Menschen und Planeten hervorzubringen. Die Vision: KI von einer kommerziellen Determinante der Gesellschaft zu einer sozialen Determinante des Lebens umzuformen. Design-Ansätze aus der Forschung zeigen: KI kann darauf ausgelegt werden, prosoziale Verhaltensweisen zu fördern. Beispielhaft ist auch der KI-gestützte DebunkBot, welcher von MIT-Forschern wirkt Rage-Bait engegen, in dem er den Glauben an Verschwörungstheorien durch personalisierte, evidenzbasierte Dialoge um durchschnittlich 20 Prozent reduziert. Derzeit wirken viele dieser Projekte wie utopische Visionen. Aber vielleicht braucht die Branche genau solche Gedankenexperimente, um den Weg vom „Schneller, Größer, Mehr" zum „Besser, Friedlicher, Gemeinsam" zu finden. Herausforderung: Wer definiert „menschliches Verhalten"?In Vince Gilligans TV-Serie "Pluribus" (2025) kämpft Protagonistin Carol Sturka (Rhea Seehorn) gegen eine Welt, in der ein außerirdisches Virus die Menschheit in einen friedlichen, zufriedenen Schwarmgeist verwandelt hat. Die Infizierten werden zwar dauerhaft glücklich, friedlich und kooperativ, verlieren dabei aber ihre Individualität, ihren freien Willen und die Fähigkeit, das volle Spektrum menschlicher Emotionen zu empfinden. Carol gehört zu den wenigen Immunen und weigert sich, diese scheinbare Utopie zu akzeptieren. Die Serie kritisiert den Verlust individuellen Denkens und persönlicher Autonomie, der entsteht, wenn Konformität über alles gestellt wird. Die zentrale Frage lautet: Kann „wahres" Glück erzwungen werden? Darf man das Individuum der (programmierten) Zufriedenheit des Kollektivs opfern? Sind Hass-Kommentare und Fake-News im Internet ein Ausdruck der individuellen, freien Meinunsäußerung? Wo endet dieses Recht - und wo beginnt Zensur? Darf ich mich ungesund ernähren auch wenn ich weiß, dass es mir schadet und die Krankenkassen belastet?

In ihrer Allgemeinen Erklärung der Menschenrechte von 1948 formuliert der UN: „Alle Menschen sind frei und gleich an Würde und Rechten geboren. Sie sind mit Vernunft und Gewissen begabt und sollen einander im Geist der Brüderlichkeit begegnen." Dies beschreibt weniger, was menschliches Verhalten ist, sondern wie es, nach Ansicht der UN, idealerweise sein sollte – ein ethischer Maßstab statt einer wissenschaftlichen Definition. Kann sich die Menschheit nach fast 80 Jahren noch auf diesen ethischen Maßstab einigen? Entspricht dieser Maßstab tatsächlich der menschlichen Natur? |

| © 2001-2025 | Über Dirk | Datenschutz | Impressum |